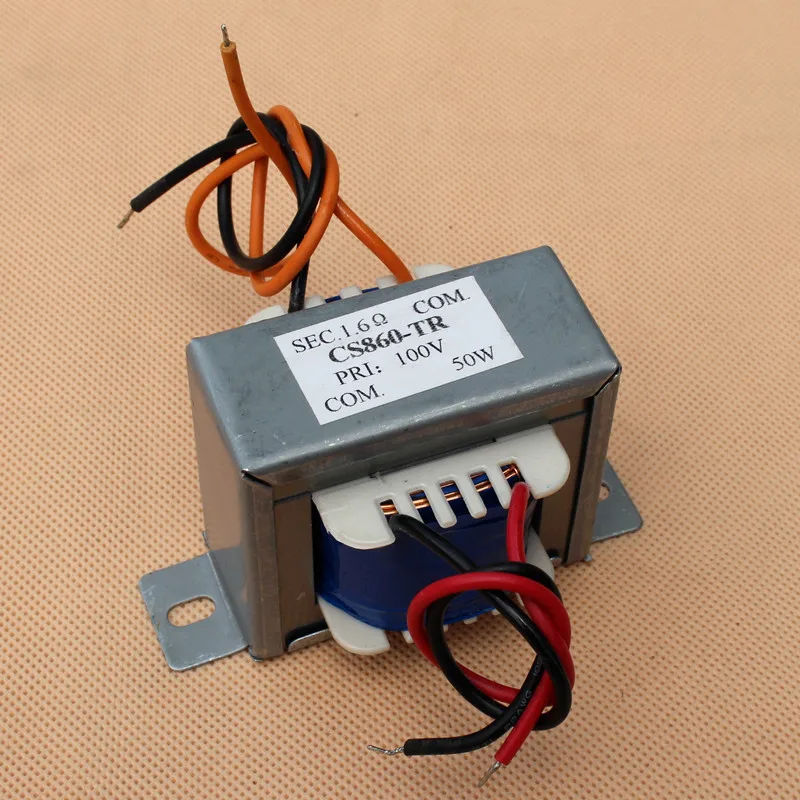

30. Линейный трансформатор

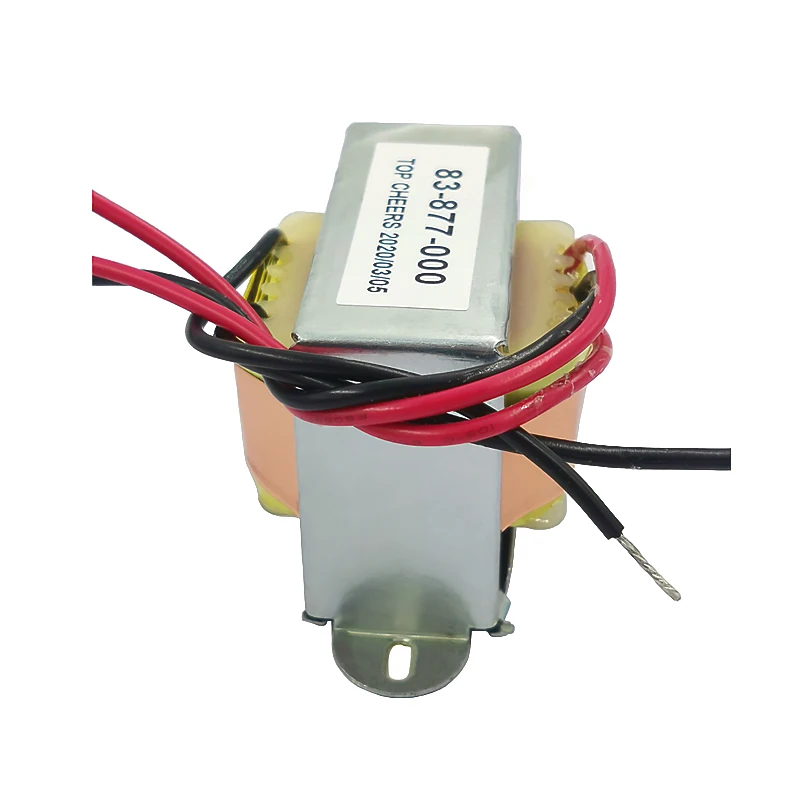

Линейный трансформатор — регулировочный трансформатор, служит для регулирования напряжения, возникающего в электрической сети, одна из обмоток которого последовательно включена в сеть.

Трансформатор — важнейшая часть электрической цепи, которая служит для преобразования значений токов и напряжений. Простейший линейный трансформатор состоит из двух неподвижных и гальванически несвязанных катушек без ферромагнитного сердечника. Подобный агрегат называется воздушным и считается линейным трансформатором. При использовании ферромагнитного сердечника линейный трансформатор приобретает нелинейные свойства.

Линейные

трансформаторы и последовательные

(регулировочные) трансформаторы

используются для изменения напряжения

в отдельной или группе линий. Линейный

(или регулировочный) трансформатор —

это такой статический электроаппарат,

который состоит из последовательного

и питающего трансформаторов. Они

применяются, чтобы реконструировать

существующие сети, где используют

трансформаторы без регуляции под

нагрузкой.

31.Понятия о трёхфазных источниках эдс и тока.

Трехфазная цепь— цепь, в ветвях которой действуют три одинаковые по амплитуде синусоидальные ЭДС, имеющие одну и ту же частоту, сдвинутые по фазе одна относительно другой на угол 2π/3 (120°). Каждая из действующих ЭДС находится в своей фазе периодического процесса, поэтому часто называется просто «фазой».

Источником

трехфазного напряжения является

трехфазный генератор, на статоре которого

(рис. 1) размещена трехфазная обмотка.

На рис. 1 каждая фаза статора условно

показана в виде одного витка. Начала

обмоток принято обозначать заглавными

буквами А,В,С, а концы- соответственно

прописными x,y,z. ЭДС в неподвижных обмотках

статора индуцируются в результате

пересечения их витков магнитным полем,

создаваемым током обмотки возбуждения

вращающегося ротора (на рис. 1 ротор

условно изображен в виде постоянного

магнита). При вращении ротора с равномерной

скоростью в обмотках фаз статора

индуцируются периодически изменяющиеся

синусоидальные ЭДС одинаковой частоты

и амплитуды, но отличающиеся вследствие

пространственного сдвига друг от друга

по фазе на 2π/3 радиан.

32.Расчёты трёхфазных цепей в симметричном и несимметричном режимах.

Симметричная система (ЭДС, напряжений, токов и т.д.) – система, состоящая из 3 одинаковых по модулю векторов ЭДС (напряжений, токов и т.д.), сдвинутых по фазе друг относительно друга на одинаковый угол 2π/3. Векторная диаграмма для симметричной системы ЭДС, соответствующей трехфазной системе синусоид на рис. 2, представлена на рис. 3. Расчет таких цепей проводится для одной – базовой – фазы, в качестве которой обычно принимают фазу А. При этом соответствующие величины в других фазах получают формальным добавлением к аргументу переменной фазы А фазового сдвига 2π/3 при сохранении неизменным ее модуля:

eA=EA*sinωt,eB=EB*sin(ωt-2π/3),eC=EC*sin(ωt-4π/3).

Если

хотя бы одно из условий симметрии не

выполняется, в трехфазной цепи имеет

место несимметричный режимработы.

Такие режимы при наличии в цепи только

статической нагрузки и пренебрежении

падением напряжения в генераторе

рассчитываются для всей цепи.

что это, характеристики регулировочных агрегатов, схемы

Автор Andrey Ku На чтение 4 мин Опубликовано

Линейные трансформаторы устанавливаются в электрических цепях для возможности регулирования подаваемого напряжения при снижении рабочей мощности. Катушки создают электромагнитное поле, которое разряжается, когда уменьшается сила тока в цепи. Таким образом обеспечивается подача стабильного электричества.

При их изготовлении не используются ферромагнитные сердечники. Эта особенность позволяет регулировать напряжение в сети. Специальные трансформаторы изготавливаются для уменьшения напряжения на высоковольтных линиях с 6, либо 10 кВ до 230 или 115 В.

Содержание

- Для чего служит?

- Преимущества использования

- Схема линейного трансформатора

- Где применяют?

Для чего служит?

Такие трансформаторы используются для регулирования объемов электричества, проходящего по электрической сети. Каждая катушка последовательно включается в сеть. Это важный элемент электрической цепи, изменяющий силу тока и напряжения. Прибор изготавливается из пары неподвижных катушек, в которых не используются ферромагнитные сердечники. Такие устройства называются воздушными и относятся к категории линейных. Они изготовлены без ферромагнитных сердечников.

Каждая катушка последовательно включается в сеть. Это важный элемент электрической цепи, изменяющий силу тока и напряжения. Прибор изготавливается из пары неподвижных катушек, в которых не используются ферромагнитные сердечники. Такие устройства называются воздушными и относятся к категории линейных. Они изготовлены без ферромагнитных сердечников.

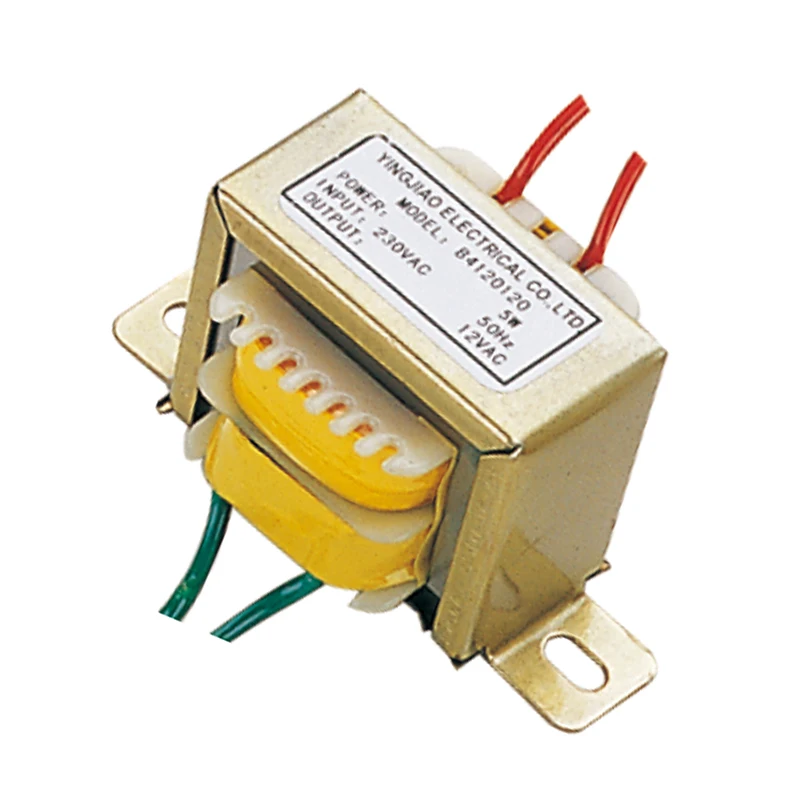

Такие приборы устанавливаются на отдельных или нескольких линиях с целью регулирования мощности. Последовательный и питающий элемент входит в основу трансформатора. Они используются для реконструкции сетей, в которых установлены не регулирующие приборы, пропускающие через себя высокую нагрузку.

Преимущества использования

Преимущества этих агрегатов по сравнению с устройствами, в которых установлен первый магнитный сердечник, заключается в возможности регулирование мощности, проходящей в цепи. Другие изделия не могут выполнять эту функцию из-за особенностей своей конструкции.

Регулировочный механизм имеет такие достоинства:

- Эффективная работа обеспечивается при разной нагрузке.

Изделие легко переносит быстрый запуск системы на максимальную мощность из выключенного состояния.

Изделие легко переносит быстрый запуск системы на максимальную мощность из выключенного состояния. - Устойчивость к коротким замыканиям.

- Хорошая защита от внешнего атмосферного воздействия, обеспечивает устойчивость к химическим и механическим воздействиям, высокому уровню влажности.

- Возможность регулировки объемов электричества позволяет экономично расходовать электроэнергию.

Особенности функционирования делают их универсальными изделиями, преобразующими электроэнергию.

Схема линейного трансформатора

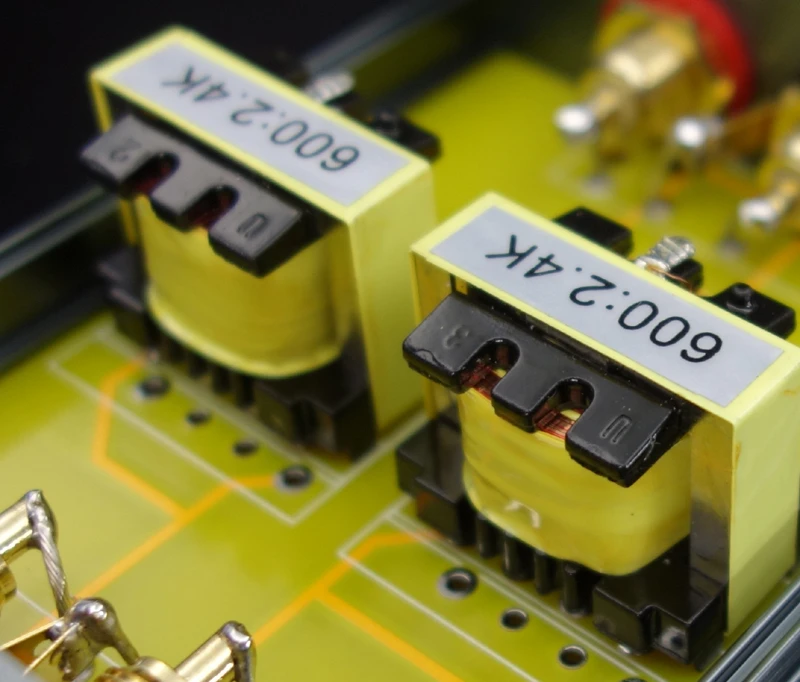

Предельный двухобмоточный трансформатор можно рассматривать в виде пары катушек с линейной индуктивностью.

Сопротивление R1 и R2 учитывает снижение энергии в парных катушках. В ситуации, когда нелинейность магнитных элементов не воздействует на свойства прибора с установленными ферромагнитными сердечниками, они рассматриваются в качестве линейных при изучении цепей с применением соответствующей схемы замещения.

Уравнение:

Данная пара уравнений равнозначна следующей:

Указанные уравнения считаются контурными для следующей схемы:

Это схема замещения, не имеющая связанных индуктивностей.

При одинаковом количестве витков на каждой обмотке индуктивность рассеивается. Работе на холодном ходу (12=0), ток в первой обмотки отличен от 0.

Это явление тока намагничивания:

Способ решения уравнений касательно электричества, проходящего через первую обмотку:

Показатели на первичной и вторичной обмотках пропорциональны в данном примере. Сопротивление нагрузки Zн всегда определяет коэффициент пропорциональности.

Трансформатор, изготовленный по такой схеме, уменьшает потери при переходе электричества с первой обмотки на вторую. Оценка КПД проводится для определения невосполнимой потери энергии. Динамические свойства тоже могут повлиять на уменьшение объемов проходящей энергии, если на мотках не предусмотрена фазировка токов. Поэтому при оценке КПД по соотношению объемов энергии, проходящей через регулировочный механизм в первой цепи с объемом, проходящим по вторичной цепи, разница не должна быть больше 0,8. Такой показатель является оптимальным для электрических установок малой и средней мощности, работающих на активную нагрузку.

Поэтому при оценке КПД по соотношению объемов энергии, проходящей через регулировочный механизм в первой цепи с объемом, проходящим по вторичной цепи, разница не должна быть больше 0,8. Такой показатель является оптимальным для электрических установок малой и средней мощности, работающих на активную нагрузку.

В обычных приборах при повышении тока в обмотках возникает накопление энергии и усиление магнитного поля. При уменьшении мощности эта энергия расходуется, и таким образом сохраняется стабильная мощность в сети. Энергия продолжает накапливаться в магнитопроводе, благодаря разрядке конденсаторов при снижении значения тока в парной катушке. Поэтому ток холостого хода значительно уменьшается.

Где применяют?

Наибольшая польза от использования регулировочных устройств получается на электростанциях, переводящих мощность одновременно с низкой и средней на высокую. Приборы без ферромагнитных стержней используются при необходимости обеспечения связи между несколькими повышенными мощностями.

Трансформаторы применяются, если на обычных автоматических механизмах не установлен РПН.

Такие устройства не используются только в небольших установках 380-220 В. Использование регулировочных изделий актуально при необходимости независимого изменения на участке низшего напряжения.

Линейные трансформаторы

Линейные трансформаторыАнгелос Катаропулос 1,2 Апурв Вьяс 1,2 Николаос Паппас 3 Франсуа Флере 1,2

1 Научно-исследовательский институт Идиап 2 Федеральная политехническая школа Лозанны 3 Вашингтонский университет

ICML 2020

Бумага

Код

Документы

Видео

Слайды Трансформаторы

демонстрируют замечательную производительность в нескольких задачах, но

из-за их квадратичной сложности по отношению к входным

длина, они чрезмерно медленны для очень длинных последовательностей. 2}$ до $\bigO{N}$, где $N$ — длина последовательности.

Мы показываем, что эта формулировка допускает итеративную реализацию

что резко ускоряет авторегрессионные преобразователи и

раскрывает их связь с рекуррентными нейронными сетями. Наш

9Линейные трансформаторы 0036 достигают характеристик, аналогичных ванильным.

трансформаторы, и они до 4000 раз быстрее на авторегрессии

предсказание очень длинных последовательностей.

2}$ до $\bigO{N}$, где $N$ — длина последовательности.

Мы показываем, что эта формулировка допускает итеративную реализацию

что резко ускоряет авторегрессионные преобразователи и

раскрывает их связь с рекуррентными нейронными сетями. Наш

9Линейные трансформаторы 0036 достигают характеристик, аналогичных ванильным.

трансформаторы, и они до 4000 раз быстрее на авторегрессии

предсказание очень длинных последовательностей.

Видеопрезентация

Интерактивная демонстрация

В нашей статье мы показываем, что замена внимания softmax на

линейное скалярное произведение карт признаков ядра $\fe{Q}$ и $\fe{K}$

позволяет нам выразить любой преобразователь как рекуррентную нейронную сеть

со следующими уравнениями обновления, где $x_i$ обозначает $i$-й

вход, $y_i$ $i$-й выход и $s_i$, $z_i$ скрытое состояние

на временном шаге $i$ (подробное описание см. T z_i} + x_i\right).

\end{выровнено}

$$

T z_i} + x_i\right).

\end{выровнено}

$$

Приведенная выше формулировка позволяет проводить эффективный авторегрессионный вывод. с линейной временной сложностью и постоянной памятью. Чтобы продемонстрировать эффективности нашей модели загружаем в браузер трансформер обучен для генерации авторегрессионного изображения и выполнения безусловная генерация изображений с помощью JavaScript в браузере. нагруженный трансформатор имеет 8 слоев и 8 головок на слой.

Следующая демонстрация не сравнивается ни с какими базовыми показателями; если ты хочешь чтобы сравнить нашу формулу со стандартным трансформатором, попробуйте наш colab. Однако эта демонстрация работает на вашем устройстве, а не на каком-либо сервере. можно даже попробовать на телефоне.

Размер партии:

Параллельная работа

Если вам интересны наши работы, вас также может заинтересовать тесно связанная параллельная работа:

- Эффективное внимание: внимание с линейными сложностями

- Linformer: Самостоятельное внимание с линейной сложностью

- Моделирование маскированного языка для белков с помощью линейно масштабируемых преобразователей длинного контекста

Благодарности

Ангелос Катаропулос и Апурв Вьяс поддерживаются SNSF в их исследованиях.

Обзор линейных трансформаторов

Введение

Преобразователи сегодня повсеместно используются в глубоком обучении. Впервые предложено в знаменитой статье «Внимание — это все, что вам нужно» Васвани и др. для задачи нейронного машинного перевода они вскоре завоевали популярность в NLP и сформировали основу для сильных предварительно обученных языковых моделей, таких как BERT и GPT. С тех пор они широко применялись в речевых задачах (см. мой другой пост о проблемах использования преобразователей в ASR), а совсем недавно — в компьютерном зрении с введением модели ViT.

Рабочая лошадка архитектуры преобразователя — это уровень самоконтроля с несколькими головками (MHSA). Здесь «самовнимание» — это способ маршрутизации информации в последовательности с использованием той же последовательности, что и направляющий механизм (отсюда «я»), и при многократном повторении этого процесса, т. е. для многих «головок», называется МХСА. Я не буду вдаваться в подробности о трансформаторе в этом посте — он уже был описан во многих визуальных деталях Джеем Аламмаром и аннотирован кодом Сашей Раш.

Самовнимание — это просто метод преобразования входной последовательности с использованием сигналов из той же последовательности. Предположим, у нас есть входная последовательность $\mathbf{x}$ длины $n$, где каждый элемент последовательности является $d$-мерным вектором. Такая последовательность может встречаться в НЛП как последовательность встраивания слов или в речи как кратковременное преобразование Фурье звука. Самостоятельное внимание использует 3 матрицы встраивания, а именно $W_Q$, $W_K$ и $W_V$, для получения матриц запросов ($Q$), ключей ($K$) и значений ($V$) для последовательности $ \mathbf{х}$. Для простоты будем считать, что все эти матрицы равны $n \times d$, хотя они могут иметь разную размерность (кроме ключей и запросов, размерность которых ограничена). Затем само-внимание производит следующее преобразование: 92)$ время и память.

- Методы, основанные на низкоранговой аппроксимации

- Методы, основанные на локально-глобальном внимании

- Методы с использованием softmax в качестве ядра

В оставшейся части этого поста я буду обсуждать документы, подпадающие под каждую из этих категорий. Обратите внимание, что это моя попытка понять, как эти разные «эффективные трансформаторы» соотносятся друг с другом. Я могу ошибаться в некоторых методах — в этом случае, пожалуйста, поправьте меня в комментариях. Отдельное спасибо за видео Янника Килчера на YouTube, которые помогли мне понять детали нескольких статей, упомянутых ниже. 9матрица T$). На следующем рисунке, взятом из статьи, мы видим, что большая часть информации в $P$ сосредоточена в нескольких собственных значениях, о чем свидетельствует крутая кумулятивная кривая суммы. Кроме того, чем глубже слой, тем ниже эмпирический ранг матрицы само-внимания, как видно на рисунке справа.

Обратите внимание, что это моя попытка понять, как эти разные «эффективные трансформаторы» соотносятся друг с другом. Я могу ошибаться в некоторых методах — в этом случае, пожалуйста, поправьте меня в комментариях. Отдельное спасибо за видео Янника Килчера на YouTube, которые помогли мне понять детали нескольких статей, упомянутых ниже. 9матрица T$). На следующем рисунке, взятом из статьи, мы видим, что большая часть информации в $P$ сосредоточена в нескольких собственных значениях, о чем свидетельствует крутая кумулятивная кривая суммы. Кроме того, чем глубже слой, тем ниже эмпирический ранг матрицы само-внимания, как видно на рисунке справа.

Затем авторы использовали лемму Джонсона–Линденштрауса, чтобы утверждать, что существует матрица низкого ранга $\tilde{P}$, которая может аппроксимировать $P$ с очень малой ошибкой. Интуитивно это работает, потому что при вычислении матрицы внутреннего внимания нас интересуют только попарные расстояния между точками. JL-лемма просто говорит, что: 9T$ теперь имеет порядок $n\times k$, а конечный результат по-прежнему равен $n\times d$. Архитектура Linformer показана ниже:

Архитектура Linformer показана ниже:

Остается только один вопрос: как выбрать подходящий $k$. Теорема 2 в статье предполагает $k=\Theta(d\log d)$ и доказывает, что при таком выборе $k$ существуют проекционные матрицы, для которых выполняется низкоранговое приближение.

Nystromformer: основанный на Nystrom алгоритм для аппроксимации собственного внимания

В этой статье также используется наблюдение низкого ранга, но вместо проекций JL используется приближение Нистрома для аппроксимации $P$. Предположим, что $P$ приблизительно имеет ранг $m$, где $m < n$. Тогда мы можем аппроксимировать $P$ следующей матрицей: 9{+}$ — это псевдообратная функция Мура-Пенроуза к $A$. Каждое вычисление теперь выполняется с матрицами меньшей размерности, линейными относительно $n$. Однако есть предостережение: для вычисления $A$ нам все равно нужно сначала вычислить $P$ из-за операции softmax (элементы $A$ нормализуются на сумму всей строки в $P$) . Это противоречит цели аппроксимации, поскольку мы делали это в первую очередь, чтобы избежать вычисления $P$.

Это противоречит цели аппроксимации, поскольку мы делали это в первую очередь, чтобы избежать вычисления $P$.

Обходной путь, предложенный в документе, заключается в выполнении приближения 9Т\право).\]

Строки $m$ формируются с использованием сегментных средних , т. е. деления всех строк на сегменты и взятия среднего значения каждого сегмента в качестве строки. Весь конвейер вычислений Nystromformer показан на рисунке ниже, взятом из статьи:

Методы, основанные на локально-глобальном внимании

Второй класс методов «разрежает» вычисления внимания, ограничивая количество токенов в последовательности, которым занимается каждый токен. Часто такой выбор делается с использованием знаний о поставленной задаче, т. е. эти методы вносят в моделирование внимания некоторые индуктивные смещения.

Longformer: преобразователь длинных документов

Идею лонжерона легче всего понять из следующего рисунка, взятого из статьи:

На рисунке (а) показана картина самоконтроля в стандартном трансформаторе. Если мы ограничим каждый элемент вниманием только к окну размером $w$, это будет паттерн оконного внимания в (б). Он похож на свертки и, следовательно, страдает от отсутствия глобального контекста. Контекст можно расширить без увеличения объема вычислений, используя расширенное внимание, как на рисунке (c). Фактический лонгформер использует глобальное внимание для конкретной задачи в дополнение к оконному или расширенному вниманию на каждом уровне, как показано на (d). Элементы, которые привлекают это «глобальное» внимание, выбираются исходя из задачи — например, 9Токен 0080 [CLS] используется для глобального внимания в задачах классификации, в то время как для контроля качества все токены вопросов получают глобальное внимание.

Если мы ограничим каждый элемент вниманием только к окну размером $w$, это будет паттерн оконного внимания в (б). Он похож на свертки и, следовательно, страдает от отсутствия глобального контекста. Контекст можно расширить без увеличения объема вычислений, используя расширенное внимание, как на рисунке (c). Фактический лонгформер использует глобальное внимание для конкретной задачи в дополнение к оконному или расширенному вниманию на каждом уровне, как показано на (d). Элементы, которые привлекают это «глобальное» внимание, выбираются исходя из задачи — например, 9Токен 0080 [CLS] используется для глобального внимания в задачах классификации, в то время как для контроля качества все токены вопросов получают глобальное внимание.

Важной деталью в работе Longformer является реализация такого шаблона внимания. Авторы предоставляют специальное ядро CUDA для реализации такого «полосного» умножения матриц, поскольку его нельзя реализовать естественным образом с помощью существующих функций в PyTorch или Tensorflow. Их реализация доступна здесь.

Их реализация доступна здесь.

Big Bird: трансформеры для более длинных последовательностей

Основная идея BigBird очень похожа на Longformer и показана на рисунке ниже, взятом из статьи:

Подобно лонгформеру, BigBird использует оконное внимание и выборочное глобальное внимание. Кроме того, он также использует «случайное внимание», когда каждый токен в последовательности обращает внимание на несколько случайно выбранных токенов (в дополнение к глобальным токенам и тем, которые находятся в его окне). Что еще более важно, авторы показывают, что этот паттерн внимания имеет ту же экспрессивность, что и стандартное полное внимание к себе, как теоретически, так и эмпирически. В частности, они показывают 2 основные вещи:

- Разреженные паттерны внимания с некоторыми «глобальными» маркерами являются универсальными аппроксиматорами, подобными полному вниманию. Для этого они используют идею «звездного графа» (в отличие от полного графа, образованного полным вниманием).

Идея состоит в том, что любая маршрутизация информации может осуществляться через центральный узел, который является глобальным токеном.

Идея состоит в том, что любая маршрутизация информации может осуществляться через центральный узел, который является глобальным токеном. - Редкое внимание также завершено по Тьюрингу. Однако в некоторых случаях может потребоваться полиномиальное количество слоев, где каждый слой является линейным. Этот вид побеждает цель линейного внимания к себе.

В целом, случайные токены отличают BigBird от Longformer, но похоже, что эти случайные токены на самом деле не нужны для теоретических гарантий. Более того, они не использовали случайные токены и в своих экспериментах BigBird-ETC (см. Таблицу 8 в Приложении). Одним из изящных приемов в статье является использование прокрутки матриц для эффективного вычисления внимания, подробно описанное в Приложении D.

.Трансформатор «длинный-короткий»: эффективные преобразователи языка и зрения 9P$ — это $d\times r$ матрица с обучаемыми параметрами. Это означает, что для каждой последовательности используется разная матрица проекций, и авторы утверждают, что это делает ее более устойчивой к вставкам, удалениям, перефразированию и т.

д. Затем краткосрочные и долгосрочные внимания объединяются с помощью двухслойной нормы (к масштабировать их), чтобы получить окончательную матрицу внимания. Весь этот механизм показан на следующем рисунке, взятом из статьи:

д. Затем краткосрочные и долгосрочные внимания объединяются с помощью двухслойной нормы (к масштабировать их), чтобы получить окончательную матрицу внимания. Весь этот механизм показан на следующем рисунке, взятом из статьи:Методы с использованием softmax в качестве ядра

Обе категории, которые мы видели ранее, использовали некоторые априорные индуктивные предубеждения относительно модели. Методы низкоранговой аппроксимации основывались на эмпирическом наблюдении, что матрица само-внимания имеет приблизительно низкий ранг, в то время как локально-глобальное внимание основывалось на идее, что только несколько токенов (часто определяемых на основе задачи) должны присутствовать глобально. ко всем токенам. Напротив, приближения на основе ядра обычно не включают никаких таких априорных значений и, как следствие, являются более надежными с математической точки зрения. Чтобы понять эту категорию линейных трансформаторов, давайте еще раз взглянем на внимание к себе. 9N \text{sim}(Q_i,K_j)},\]

9N \text{sim}(Q_i,K_j)},\]

, где $ \text{sim}(Q_i, K_j) = \frac{\text{exp}(Q_iK_j)}{\sqrt{d}}.$ Здесь sim — просто функция подобия между запросом $i$ и ключ $j$, и мы можем выбрать любую функцию ядра для этой цели. Обычно в машинном обучении используются функции ядра, чтобы избежать явного вычисления координат в больших размерностях, но в данном случае мы будем использовать их в другом направлении.

Поскольку $\text{sim}$ является ядром, существует некоторое отображение $\phi$ такое, что 9N \phi(K_j)\right)}.\]

Выражения в скобках можно вычислить один раз и использовать для всех $Q_i$ — это делает вычисление внимания линейным. Теперь единственный вопрос: как нам найти такое отображение $\phi$? К сожалению, $\phi$ для ядра softmax бесконечномерно, и поэтому мы не можем вычислить его точно! В статьях этого раздела используется описанная выше идея и делается попытка как можно лучше аппроксимировать $\phi$.

Преобразователи — это RNN: быстрые авторегрессионные преобразователи с линейным вниманием

В этой статье авторы (несколько произвольно) выбрали $\phi(x) = \text{elu}(x) + 1$, так как этот выбор приводит к положительной функции подобия. Из своих экспериментов они утверждают, что этот выбор отображения соответствует полному преобразователю.

Из своих экспериментов они утверждают, что этот выбор отображения соответствует полному преобразователю.

В другой важной части статьи (которая дала ей название «Трансформаторы — это RNN») показана эквивалентность между авторерессивными линейными преобразователями и RNN. В общем, для задач, требующих авторегрессионных вычислений, для вычисления внимания обычно используется функция каузального маскирования. Затем с помощью соответствующих манипуляций с линейным уравнением внутреннего внимания можно показать, что модель просто обновляет внутренние состояния и передает их вперед, что должно сделать ее эквивалентной RNN.

В любом случае, эта статья была, пожалуй, первой, в которой интерпретация ядра привлекла внимание softmax, и проложила путь к более строгой аппроксимации с использованием случайных признаков, которые мы увидим в следующих двух статьях. Авторы также предоставляют быструю реализацию (с использованием вычисления градиента в CUDA) и демо-версию авторерессивной генерации, которая работает в браузере, демонстрируя возможности своей модели. {-x}$, что приводит к функции подобия, которая всегда положительна. В своих экспериментах они даже заменяют 9{\prime}$, а умножение матриц можно представить в следующей форме, что приводит к линейной сложности.

{-x}$, что приводит к функции подобия, которая всегда положительна. В своих экспериментах они даже заменяют 9{\prime}$, а умножение матриц можно представить в следующей форме, что приводит к линейной сложности.

Внимание к случайным функциям

Этот документ был опубликован одновременно с докладом Performer на ICLR 2021 и предлагает ту же идею аппроксимации ядра softmax с использованием случайных функций. Аналогичное расширение работы Рахими и Рехта используется для вычисления отображения $\phi$, которое аппроксимирует функцию подобия, вычисленную softmax:

Кроме того, в этой статье также предлагается метод обучения с смещением недавности , поскольку softmax не моделирует явным образом расстояние или местоположение (отсюда важность позиционного кодирования в преобразователях). В статье «Трансформаторы — это RNN» мы видели, как можно показать, что авторегрессионные преобразователи эквивалентны RNN. Вдохновленные этой эквивалентностью, авторы в этой статье дополнительно добавляют в вычисления изученный механизм селектора, который заставляет модель больше полагаться на недавние токены.